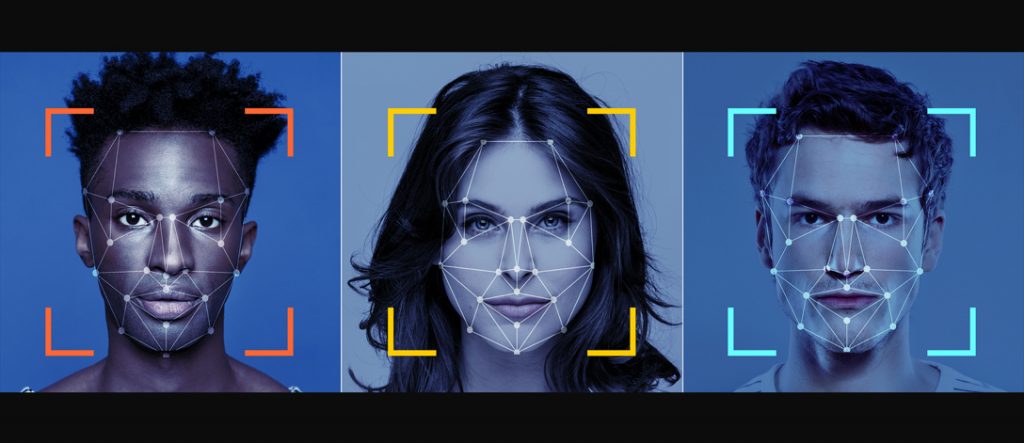

Microsoft publie la seconde version de sa « norme d’IA responsable » et promet de restreindre l’accès à ses outils d’IA, en particulier ses systèmes de reconnaissance faciale, conçus pour essayer de déterminer les émotions humaines ou encore l’âge et le sexe d’une personne à partir d’un simple portrait.

En 2015 l’éditeur avait lancé le projet Oxford, mettant à disposition des développeurs ses outils d’apprentissage automatiques dans les domaines de la reconnaissance faciale et vocale et du traitement de la parole. Mais après sept ans d’expérimentation, l’inquiétude grandit sur les problèmes de fiabilité, les questions éthiques et le cadre légal qui tarde à se mettre en place, ce qui conduit le géant américain à revoir sa position.

« Les systèmes d’IA sont le produit de nombreuses décisions prises par ceux qui les développent et les déploient. De l’objectif du système à la façon dont les gens interagissent avec les systèmes d’IA, nous devons guider de manière proactive ces décisions vers des résultats plus bénéfiques et équitables », explique Natasha Crampton, directrice de l’IA responsable de Microsoft dans un billet de blog.

Microsoft admet que les biais des modèles utilisés en IA peuvent conduire à exacerber les préjugés et les inégalités sociétales. L’entreprise s’inquiète également que ses technologies de création de voix de synthèse puissent servir à des usurpations d’identité et autres détournements de type deepfake. Enfin elle reconnait les déficiences de Microsoft Face, son système de reconnaissance facial et de détection des émotions.

« Les experts à l’intérieur et à l’extérieur de l’entreprise ont souligné l’absence de consensus scientifique sur la définition des « émotions », les défis liés à la généralisation des inférences dans les cas d’utilisation, les régions et les données démographiques, et les préoccupations accrues en matière de protection de la vie privée liées à ce type de capacité », souligne Natasha Crampton.

Dans ce contexte, Microsoft choisit donc de ne plus donner accès à ces technologies aux nouveaux clients. Les clients existants auront jusqu’au 30 juin 2023 pour migrer vers d’autres services. Leur utilisation restera ensuite interne, avec un cadre de contrôle pour déterminer les cas d’utilisation acceptables et s’assurer que les systèmes d’IA soient responsable dès leur conception.

Microsoft considère que pour qu’un système d’IA soit fiable, il doit apporter une solution appropriée au problème pour lequel il a été conçu. Un des cas où ses technologies continueront d’être utilisées sera par exemple Seeing Ai, une application sur smartphone qui apporte aux personnes malvoyantes des informations vocales sur l’environnement qui les entoure.